KIOXIA E1.S SSD’ler

KIOXIA E1.S SSD’ler

KIOXIA E1.S SSD’ler Yapay Zeka İş Akışlarını Daha Verimli Hale Getiriyor

KIOXIA E1.S SSD’ler Yapay zeka için yoğun GPU sunucuları hakkında önemli miktarda abartılı reklam olsa da, ki haklı olarak da öyle, gerçek şu ki çoğu yapay zeka eğitim projesi iş istasyonlarında başlıyor. Artık tek bir iş istasyonuna dört adede kadar NVIDIA A6000 Ada GPU’yu sıkıştırabilsek de, daha zorlu olan şey bu AI kutularında sağlam depolama elde etmektir. Bu konuyu düşündük ve birkaç yapay zeka iş istasyonuna yüksek hızlı depolamayı en iyi şekilde sağlamak için bir plan hazırladık. Çıkarım hilesi içeren inanılmaz derecede yetenekli bir 1U depolama sunucusu oluşturmak amacıyla bir sunucuyu 24 adet 7,68 TB XD7P Serisi Veri Merkezi NVMe SSD’lerle doldurmak için Supermicro ve KIOXIA ile birlikte çalıştık.

Ne düşündüğünüzü biliyoruz: E1.S SSD’lerle doldurulmuş bir sunucu platformu, yapay zeka modellerini eğiten iş istasyonları ve aynı depolama sunucusunda çıkarım yapma arasındaki noktaları nasıl birleştirmeyi düşünüyorsunuz? Açıklamak için biraz serbestlik tanıyın.

Yapay Zeka İş İstasyonlarının Masa Altında Olması Gerekmiyor

KIOXIA E1.S SSD’ler Birkaç istisna dışında, pahalı GPU’lara sahip yüksek güçlü yapay zeka iş istasyonları muhtemelen uç noktalara veya muhtemelen bir ofis binasının içine bile dağıtılmamalıdır. Sorunlar çoktur. Öncelikle bu uç noktalar yüksek güvenlik tehditleri ve veri sızıntısı riskiyle karşı karşıyadır ve daha da önemlisi, yetersiz kullanımdan zarar görürler. Çoğu yapay zeka uzmanı, yetersiz LAN yapılandırmaları nedeniyle modellerini eğitmek için gereken büyük miktarda veriye erişemiyor.

Öte yandan, bu güçlü iş istasyonlarını veri merkezine yerleştirirsek artık birçok fayda elde ederiz. İlk olarak, fiziksel güvenlik çözülür ve ince istemcilerle veya kablo üzerinden veri yerine yalnızca pikselleri aktaran erişimle uzaktan erişim endişeleri azaltılabilir. Bu senaryoda veriler iş istasyonu yerine sunucuda bulunur. İkincisi, veri merkezindeki bu sistemlerin yedeklenmesi daha kolay olmasa da daha hızlıdır. Üçüncüsü, akıllı provizyonla bu sistemleri dağıtılmış bir yapay zeka iş gücüyle paylaşarak şirket genelinde kullanımı artırabiliriz. Son olarak, veri merkezinde olmak bize en değerli yapay zeka varlığına, yani verilere erişim sağlar.

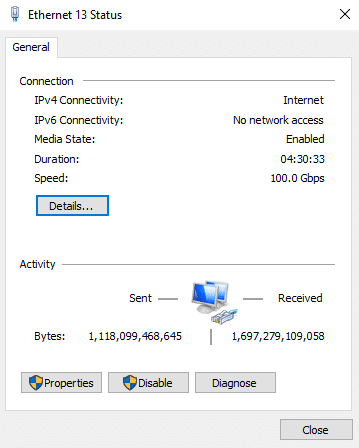

Bu iş için laboratuvarımızda bulunan üç adet Lenovo iş istasyonunu tedarik ettik. Her biri biraz farklı yapılandırılmıştır, hem AMD hem de NVIDIA GPU’lardan yararlanır ve bazı modeller farklı hızlandırıcılarda daha iyi performans gösterebileceğinden esneklik sağlar. Her sistemde yüklü bir NVIDIA ConnectX-6 100GbE kartı bulunur; bu, bu sistemlerin depolamaya hızlı erişime sahip olmasını sağlamak için temel önem taşır. Daha sonra her sistem, depolama hizmetinin de bağlı olduğu bir Dell Z9100 100GbE anahtarına bağlanır.

| Parça | İş istasyonu 1 | İş İstasyonu 2 | İş İstasyonu 3 |

| Modeli | Lenovo P620 | Lenovo P620 | Lenovo P5 |

| İşlemci | AMD Ryzen Threadripper PRO 5995WX | AMD Ryzen Threadripper PRO 3995WX | Intel Xeon w7-2495X |

| Hafıza | 128 GB DDR4 3200 | 32 GB DDR4 3200 | 32GB DDR5 4800Mhz |

| GPU | AMD Radeon PRO W7900 | NVIDIA RTX A6000 | NVIDIA RTX A4500 |

KIOXIA XD7P Serisi SSD’lerle Hızlı Yapay Zeka Depolama

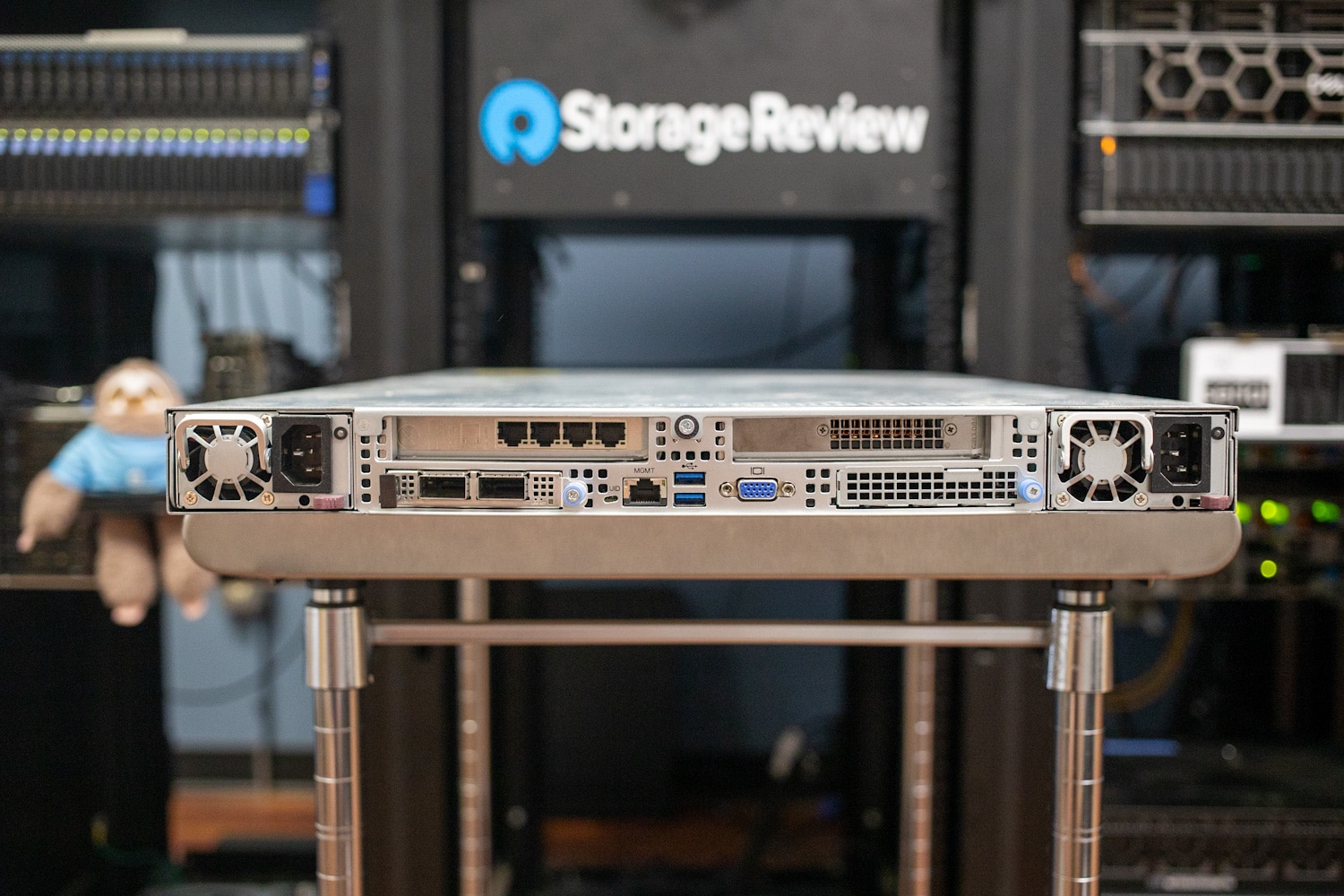

AI iş istasyonu test ortamı sıralandıktan sonra depolama sunucusuna dönüyoruz. Bu durumda Supermicro Storage SuperServer SSG-121E-NES24R kullanıyoruz . Bu 1U sunucu, 2,00 GHz temel frekansına sahip 28 çekirdekli ve 56 iş parçacıklı çift Intel Xeon Platinum 8450H işlemciye sahiptir. 8450H işlemciler, 75 MB önbelleğe ve 250 W TDP’ye sahipken maksimum 3,50 GHz turbo frekansına ulaşabiliyor. 512GB DDR5 RAM nispeten mütevazı bir RAM alanıdır. Sunucu, bağlantı için iş istasyonlarıyla aynı NVIDIA ConnectX-6 100GbE NIC’yi kullanır. Ayrıca çıkarım yapmak için bir NVIDIA A2 GPU kurduk.

Depolamaya gelince, KIOXIA bize 24 adet XD7P Serisi Veri Merkezi NVMe SSD’leri gönderdi. KIOXIA XD7P Serisi E1.S SSD’ler, özellikle Açık Hesaplama Projesi (OCP) Veri Merkezi NVMe SSD Spesifikasyonunda belirtilen performans, güç verimliliği ve termal gereksinimlerle ilgili olarak modern veri merkezlerinde bulunan hiper ölçekli uygulamaların ihtiyaçlarını karşılamak üzere özel olarak tasarlanmıştır.

Bu SSD’ler, 9,5 mm ve 15 mm kalınlığındaki E1.S çeşitleriyle mevcuttur; ikincisi, ısı dağıtımını artırmak için bir soğutucuya sahiptir. KIOXIA’nın XD7P’nin denetleyici, donanım yazılımı ve 5. nesil BiCS FLASH™’den oluşan tescilli mimarisi, genel verimliliğe, güvenilirliğe ve performansa katkıda bulunur. Yeni seri, değişen depolama taleplerini karşılamak için 1,92 TB ile 7,68 TB arasında değişen kapasitelerde sunuluyor.

KIOXIA E1.S SSD’ler Bazı temel özellikler arasında, beklenmeyen güç kaybı içeren senaryolarda veri bütünlüğünü korumak için kritik olan güç kaybı koruması (PLP) ve uçtan uca veri koruma yer alır. Ayrıca, kendi kendini şifreleyen sürücü (SED) teknolojisinin varlığı ekstra bir veri güvenliği katmanı ekler.

Performans açısından, KIOXIA XD7P Serisi SSD’ler farklı kapasitelerde etkileyici potansiyel sayılar sunar. Daha büyük kapasiteler için 7.200 MB/s’ye kadar sürekli sıralı okuma hızları ve 4.800 MB/s’ye kadar sıralı yazma hızları ile bu SSD’ler, veri yoğunluklu görevleri verimli bir şekilde yerine getirmek üzere tasarlanmıştır. Ek olarak, sırasıyla 1.650K IOPS ve 200K IOPS’ye kadar sürdürülebilir rastgele okuma ve yazma hızları, onları yüksek I/O işlemleri gerektiren iş yükleri için uygun hale getirir.

XD7P, performans ve yoğunluk arasında benzersiz bir denge kurmak için E1.S form faktöründen yararlanır. Bu, yeni sürücüleri bulutta ve hiper ölçekli veri merkezlerinde flash depolama için ileriye dönük bir çözüm olarak konumlandırıyor ve bu zorlu ortamların gelişen gereksinimlerine hitap ediyor. XD7P’nin standartlaştırılmış boyutu ve yerleşik soğutucuları, 1U SuperServer SSG-121E-NES24R’de öne monte edilen 24 sürücümüzü barındırmak için etkili bir yol sağlayarak sunucu yoğunluğunu önemli ölçüde artırır. Ayrıca, E1.S’nin çalışırken değiştirilebilme özelliği, yüksek performanslı iş yüklerini termal kaygılar olmaksızın kaldırabilme yeteneği ile birleştiğinde, onu veri merkezleri gibi depolama çözümleri için geliştirilmiş verimlilik ve performansla veri merkezlerindeki M.2 konektörünün pratik bir alternatifi olarak konumlandırıyor. .

XD7P, PCIe Gen4 x4 hatlarını destekler. Sürücü, Gen4 veya Gen5 arka panelleriyle iyi çalışır.

KIOXIA XD7P Serisi Hızlı Özellikler

| Kapasite | 7.680 GB | 3.840 GB | 1.920 GB | 7.680 GB | 3.840 GB | 1.920 GB |

| Temel Özellikler | ||||||

| Form faktörü | E1.S 15mm | E1.S 9,5 mm | ||||

| Arayüz | PCIe 5.0, NVMe 2.0 | |||||

| Flaş Bellek Türü | BiCS FLASH TLC | |||||

| Performans (En fazla) | ||||||

| Sürekli 128 KiB Sıralı Okuma | 7.200 MB/sn | |||||

| Sürekli 128 KiB Sıralı Yazma | 4.800 MB/sn | 3.100 MB/sn | 4.800 MB/sn | 3.100 MB/sn | ||

| Sürekli 4 KiB Rastgele Okuma | 1.550.000 IOPS | 1.650.000 IOPS | 1.500.000 IOPS | 1.550.000 IOPS | 1.650.000 IOPS | 1.500.000 IOPS |

| Sürekli 4 KiB Rastgele Yazma | 200K IOPS | 180K IOPS | 95.000 IOPS | 200K IOPS | 180K IOPS | 95.000 IOPS |

| Güç Gereksinimleri | ||||||

| Besleme gerilimi | 12 V ± %10 | |||||

| Güç Tüketimi (Aktif) | 20 W tip. | 20 W tip. | 16W tip. | 20 W tip. | 20 W tip. | 16W tip. |

| Güç Tüketimi (Hazır) | 5 W tip. | |||||

| Güvenilirlik | ||||||

| MTTF | 2.000.000 saat | |||||

| DWPD | 1 | |||||

KIOXIA XD7P Serisi SSD’lerle Depolama Sunucusu Performansı

KIOXIA E1.S SSD’ler Bu kombinasyonun ne kadar iyi performans gösterebileceğini daha iyi anlamak için, dahili performans testleriyle depolama sunucusunu sarsarak başladık. Depolama sunucusunun performansına bakarken, depolamanın neler yapabileceğini karakterize etmek için Ubuntu Linux’taki JBOD yapılandırmasındaki tam ham performansa odaklandık.

4K rastgele iş yüküyle en yüksek verimi ve ardından 64K sıralı iş yüküyle en yüksek bant genişliğini inceledik. Bu testler, bir Ubuntu 22.04 ortamında VDbench’ten yararlanılarak gerçekleştirildi.

| İş yoğunluğu | Okumak | Yazmak |

|---|---|---|

| 64K Sıralı, 64 İplik Yükü | 158 GB/sn | 64,1 GB/sn |

| 4K Rastgele, 512 Konu Yükü | 4,09M IOPS, 16 GB/sn | 4,5M IOPS, 17,7 GB/sn |

Deney kurulumumuzda, yüksek hızlı KIOXIA sürücülerinden yararlanmak için Windows Depolama Alanlarını SMB3 protokolüyle birlikte kullanmaya karar verdik. Dayanıklı, yansıtılmış bir depolama havuzu oluşturmak için Depolama Alanlarından yararlanarak veri bütünlüğünü sağlamayı ve G/Ç performansını optimize etmeyi başardık.

SMB3’ün çok kanallı yetenekler ve kalıcı işlemeler gibi gelişmiş özellikleri, genellikle daha yavaş, CPU’ya bağlı bellekle ilişkilendirilen geleneksel darboğazları atlayarak, büyük veri yığınlarının yüksek verimle birden fazla GPU iş istasyonuna doğrudan aktarılmasına olanak tanır. Bu kurulum, birden fazla iş istasyonunun KIOXIA destekli paylaşımlı depolama alanımıza aynı anda erişmesine ve buradan veri yüklemesine izin verirken hızlı veri alımını sağlama gibi ikili bir avantaja sahipti.

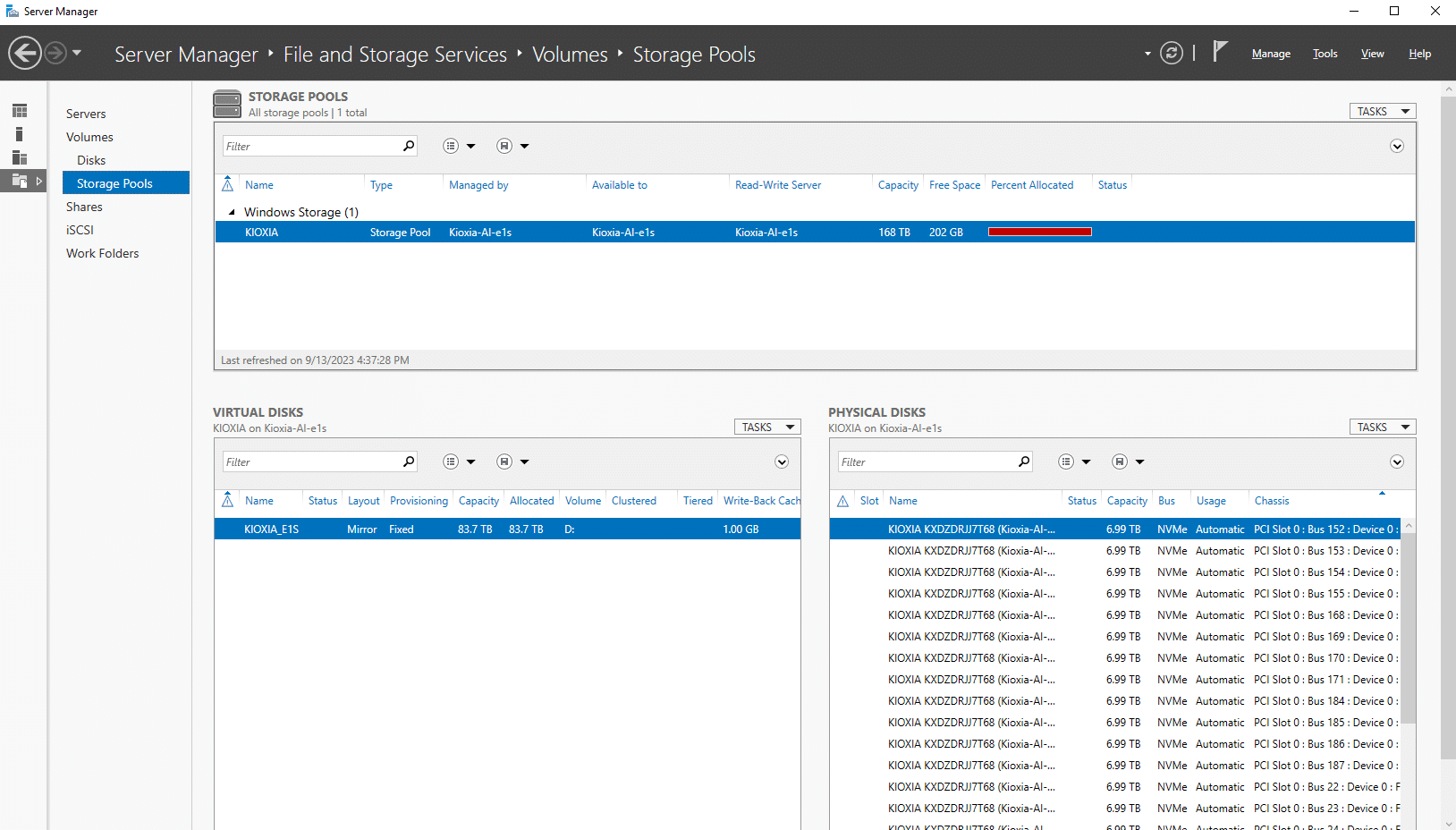

Önceki testlerimizde KIOXIA XD7P Serisi SSD’lerin dosya sistemi olmadan ham performansı ölçülürken, Windows Server 2022 ortamındaki performansa ikinci kez baktık. Bu kurulumda, büyük depolama havuzumuzdaki yansıtılmış sanal diskle NTFS dosya sistemini kullandık.

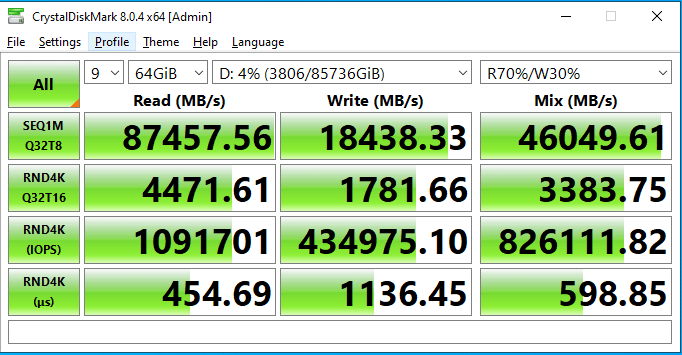

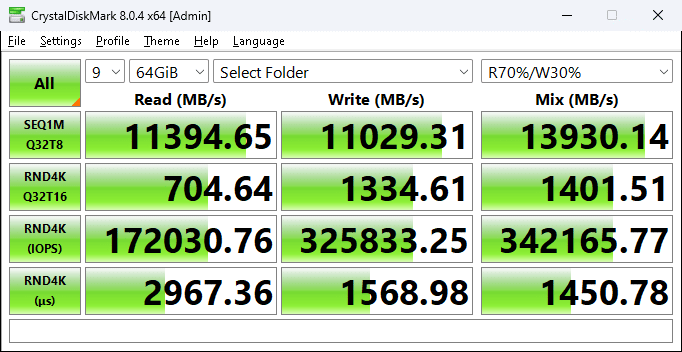

Yansıtılmış birimimizin güçlü performansını doğrulamak için sunucuda yerel olarak CrystalDiskMark’tan yararlandık. Bu test, 1 MB aktarım boyutunun yanı sıra rastgele 4K aktarım hızlarıyla sıralı okuma ve yazma performansını ölçmek için ayarlandı. Burada 64 GB dosya alanıyla 87,4 GB/s okuma ve 18,4 GB/s yazma hızını ölçtük.

Bu yazıda tüm yapay zeka çözümünün genel yeteneklerine bakıyoruz; bu tür bir performans profiline sahip olmak etkileyici olsa da KIOXIA açıkça bize ihtiyacımız olandan fazlasını veriyor. Bu iyi bir şey çünkü bu, yapay zeka iş istasyonlarının sayısını kolayca artırabileceğimiz veya verilerimizi temizleme ve temizleme veya tamamen başka bir şey olsun, depolama sunucusuna ek görevler atayabileceğimiz anlamına geliyor.

Yapay Zeka İş İstasyonlarını Besliyor Bol Yüksek Hızlı Depolama

Laboratuvar rafında bulunan GPU iş istasyonlarımız, KIOXIA tabanlı tamamen flash 1U dosya sunucumuza 100GbE ile ağ bağlantısı yapılmış ve paylaşımlar kurulmuşken, bunu pratikte test etmek için yola çıktık. Test kurulumumuzda, her iş istasyonundan Dell Z9100 100GbE anahtarımıza temel tek bir 100GbE bağlantısını tercih ettik ve bu anahtar daha sonra başka bir 100GbE bağlantıyla depolama sunucusuna geri bağlandı.

Burada, KIOXIA depolama sunucumuzdaki Windows dosya paylaşımından etkileyici bir 11,4 GB/s okuma ve 11 GB/s yazma hızı ölçebildik.

Yapay zeka iş istasyonlarına giden bu seviyedeki performans ve yoğunluk, muazzam bir değer sağlayacaktır. Yapay zeka iş istasyonlarını yerel depolamayla doldurmaya çalışmak yerine, kapasite açısından neredeyse sınırsız olan 100GbE üzerinden daha da yüksek performanslı depolamayı paylaşabiliriz.

Uygulamada GenAI – LLM Eğitim Veri Setleri

Büyük Dil Modelleri (LLM’ler) bugünlerde BT bloğundaki en popüler çocuklardır. Bunları eğitmek ve ince ayar yapmak, muazzam veri kümeleri ve bunları işlemek için daha da büyük GPU beygir gücü gerektiren devasa bir girişimdir. Bazı GPU iş istasyonlarını yüklemek ve bazı gerçek dünya tarzı testleri yapmak için, 2012’den 2021’e kadar tüm metin Reddit gönderimlerinin ve yorumlarının bir dökümünü, bazı ayarlamalarla birlikte, Stanford Alpaca eğitim veri setini birden fazla ince ayar için LLaMa modeline aldık . denemeler. Amaç, büyük ölçekli gerçek dünya veri kümelerine tabi tutulduğunda LLaMa modelinin verimliliğini, doğruluğunu ve uygulanabilirliğini değerlendirmekti.

Windows Server 2022 platformundan 24 KIOXIA XD7P Serisi SSD, 168 TB’lık bir havuzda ve ardından 83,7 TB’lık yansıtılmış birimde gruplandı. Bu birim daha sonra 100GbE ağı üzerinden, yararlanılacak üç iş istasyonunun her birine bir dosya paylaşımıyla paylaştırıldı. Kullanılan Supermicro Superserver depolama sunucusu, performansı etkilemeden 84 TB’lık hacmin tamamını dolduran veri boyutunu işleyebilir. Kullanılan mevcut veri boyutu 5,6 TB’tır, ancak birim çok daha büyük bir boyutu işleyebilir.

Her GPU iş istasyonu, çeşitlilik içeren bir ortam sağlamak amacıyla biraz farklı yapılandırıldı. Her makineye, ortak bir veri seti üzerinde farklı modellerle çalışan bireysel bir geliştirici gibi davrandık ve herhangi bir eğitim dağıtmadık. Bu bağlamda Windows’un seçimi, erken bir araştırma veya geliştirme senaryosunu taklit etmekti.

Ele aldığımız veri ölçeğine ilişkin bağlam açısından, bu teste yönelik veri kümelerimiz, 3,7 TB disk alanı tüketen LLM eğitim verileri için 16.372 dosyadan ve 1,9 TB yer kaplayan görüntü eğitim verileri için başka 8.501 dosyadan oluşuyordu. Toplamda 5,6 TB büyüklüğünde 24.873 dosyayla çalıştık. Veri setlerimizin boyutunu kasıtlı olarak kısıtladığımızı ve bu deneyler için depolama kapasitesinin tamamını kullanmadığımızı unutmamak önemlidir; aksi takdirde eğitim veya ince ayar süreci bu proje için zaman kısıtlayıcı olurdu. Bu yapılandırmayla tüm iş istasyonları veri kümelerini paylaşabildi ve işbirliği için kontrol noktalarını ve parçaları sunucuya kaydedebildi.

| Dosyalar | Diskteki boyut | |

| Yüksek Lisans Eğitim Verileri | 16.372 | 3,7 TB |

| Görüntü Eğitim Verileri | 8.501 | 1,9 TB |

| Toplam | 24.873 | 5,6 TB |

Her iki deneyimizin yazılım yığını basit bir konfigürasyondu ve Anaconda’nın ve Linux için Windows Alt Sisteminin (WSL) gücüne güvendik . Anaconda, Python tabanlı makine öğrenimi kitaplıklarımızı ve bağımlılıklarımızı yönetmek için sağlam bir ortam sağlayarak GPU iş istasyonlarımızda modüler ve kolayca kopyalanabilir bir kuruluma olanak tanır. WSL, Windows ve Linux tabanlı yardımcı programlar arasındaki boşluğu doldurmaya yardımcı olarak, Linux’a özgü veri işleme ve düzenleme araçlarını Windows iş istasyonlarımızda sorunsuz bir şekilde çalıştırma esnekliği sunar. Veri ön işleme için kabuk komut dosyalarını çalıştırabilir ve Python tabanlı eğitim işlerini birleşik bir iş akışı içinde başlatabiliriz. Bu rotayı seçmemizin nedenlerinden biri yalnızca yapılandırma kolaylığı değil, aynı zamanda karma GPU ortamımızla oyun alanını eşitlemekti.

Eğitim sürecinde birkaç önemli gözlem yapıldı:

- Veri Çeşitliliği: Neredeyse on yıla yayılan Reddit gönderimleri ve yorumlarının birleştirilmesi, modele konuların, sözlüklerin ve konuşma bağlamlarının eklektik bir karışımını sundu. Bu zengin çeşitlilik, modelin zaman içinde çeşitli nüansları, duyguları ve kültürel değişimleri anlaması ve bunlara uyum sağlaması için kapsamlı bir platform sağladı.

- Model Ölçeklenebilirliği: Bu kadar büyük miktarda verinin işlenmesi, LLaMa modelinin ölçeklenebilirliği açısından bir turnusol testiydi. Eğitim dönemleri arttıkça modelin ilgili yanıtları tahmin etme ve oluşturma yeteneğinin önemli ölçüde arttığını ve bu durumun büyük ölçekli uygulamalara yönelik potansiyelini ortaya çıkardığını gördük. Aşırı uyum yaklaşık yarım düzineden sonra bir endişe kaynağıydı ancak bu test için mutlaka bir endişe kaynağı değildi, çünkü amaç genel bir Yüksek Lisans modeli oluşturmaktan ziyade GPU’larımızı ve ağ paylaşımımızı daha fazla yüklemekti.

- Kaynak Optimizasyonu: Gereken muazzam GPU gücü göz önüne alındığında, hesaplama kaynaklarının verimli kullanımını sağlamak çok önemliydi. Optimum performansı sağlamak için dinamik yük dengeleme, periyodik kontrol noktaları ve anında veri artırma teknikleri kullanıldı.

- Transfer Öğrenme Potansiyeli: Stanford Alpaca eğitim veri setini Reddit verileriyle birlikte kullanmak, modelin transfer öğrenme yeteneklerini ölçmede etkili oldu. Alpaca veri setinin doğal yapısı ve akademik doğası, Reddit verilerinin resmi olmayan ve çeşitli doğasıyla bir araya geldiğinde heyecan verici bir zorluk ortaya çıktı. Sonuçlar, LLaMa’nın farklı kaynaklardan gelen bilgileri sorunsuz bir şekilde entegre ederek onu çok yönlü ve uyarlanabilir hale getirdiğini gösterdi.

- Etik Hususlar: Geniş Reddit veri seti bir bilgi hazinesi sunarken, kişisel olarak tanımlanabilir bilgilerin hariç tutulmasını ve verilerin etik ve sorumlu bir şekilde kullanılmasını sağlamak çok önemlidir. Kullanıcı gizliliğini korumak amacıyla modelin yayınlanması için sıkı veri temizleme ve anonimleştirme süreçlerinin uygulamaya konması gerekecektir.

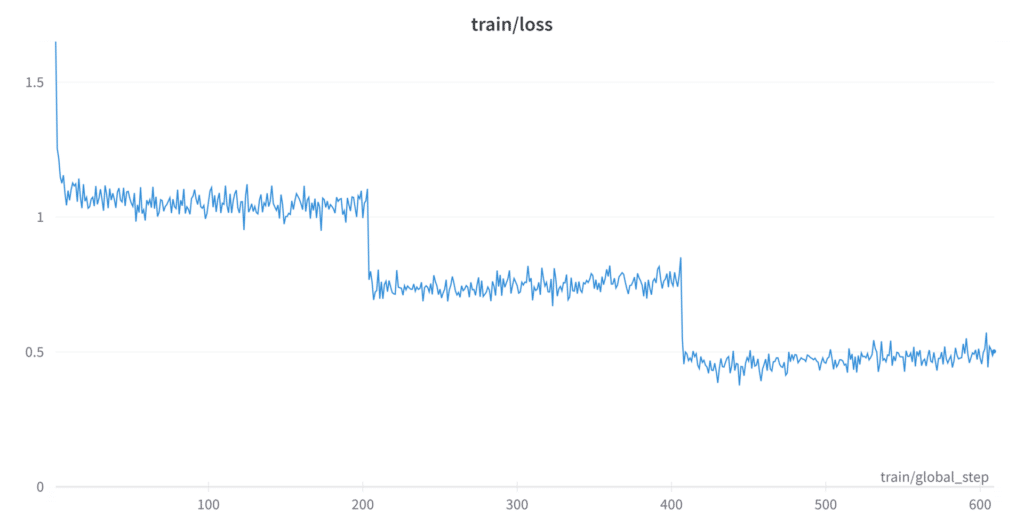

Bu egzersiz, KIOXIA’nın yüksek yoğunluklu sürücülerinin eğitim verimliliğimizi artırmada oynadığı önemli rolün altını çizdi. Veri kümelerinin muazzam boyutu ve model eğitiminin yinelemeli doğası göz önüne alındığında, depolama hızı ve kapasitesi bu tür deneylerde genellikle darboğazlardır. KIOXIA’nın sürücüleri sayesinde, veri kümesinin birden fazla örneğini, ara model ağırlıklarını ve düzinelerce ince ayarlı kontrol noktasını depolama lüksüne sahip olduk. Hızlı okuma ve yazma hızları, hızlı veri alımını kolaylaştırdı ve aşağıda gösterildiği gibi farklı hiper parametrelerle ince ayarın birden fazla yinelemesini paralel olarak işlememize olanak sağladı.

Bu, en uygun çalışma kontrol noktasını belirleme arayışımızda çok önemliydi. Yeni inşa ettiğimiz KIOXIA destekli depolama sunucumuz sayesinde, depolama sınırlamalarıyla kısıtlanmak yerine modeli iyileştirmeye, parametreleri ayarlamaya ve sonuçları değerlendirmeye odaklanabildik. Bu nedenle yüksek yoğunluklu sürücüler yalnızca bir depolama çözümü değil aynı zamanda deney aşamamızı önemli ölçüde hızlandıran önemli bir varlıktı. Bu, LLaMa modelinin potansiyelinin daha kapsamlı ve verimli bir şekilde araştırılmasını sağladı ve kendi yeni evrişimli sinir ağımızı (CNN) geliştirmemize olanak sağladı.

Deneyimsiz olanlar için , evrişimli bir sinir ağı (CNN), ağırlıklı olarak görüntü işleme ve bilgisayarlı görme görevlerinde kullanılan özel bir derin öğrenme mimarisi türüdür. Onun ayırt edici özelliği, giriş görüntülerinden özelliklerin mekansal hiyerarşilerini otomatik ve uyarlanabilir bir şekilde öğrenen evrişimli katmanlarda yatmaktadır. Tamamen bağlantılı katmanlara dayanan geleneksel sinir ağlarının aksine, CNN’ler, giriş verilerini küçük parçalar veya alıcı alanlarda işleyen evrişimli filtreler uygulayarak verilerin uzamsal yapısından yararlanır. Bu, daha basit olanlardan oluşturularak kenarlar, dokular ve daha karmaşık yapılar gibi karmaşık desenleri tespit edebilen bir ağla sonuçlanır. Veriler ağın derinliklerine doğru ilerledikçe, bu modeller daha soyut hale gelir ve CNN’lerin çeşitli ve çoğunlukla karmaşık görsel varlıkları hiyerarşik olarak tanımasına ve sınıflandırmasına olanak tanır.

Çok sayıda ince ayar denemesi yoluyla model, büyük veri kümelerini verimli bir şekilde işleme yeteneğini sergiledi ve ilgili, bağlama duyarlı ve incelikli çıktılar üretme potansiyelini vurguladı. Yüksek Lisans’lar ilgi görmeye devam ettikçe, bu tür deneyler pratik uygulamaları ve sınırlamaları hakkında paha biçilmez bilgiler sunarak gelecekte daha karmaşık ve kullanıcı merkezli yapay zeka çözümlerinin önünü açıyor.

Sunucu Çıkarım Yetenekleri

KIOXIA E1.S SSD’ler Çıkarım işlemlerinin aynı veri kümesi üzerinde yürütülmesi, veri yönetimi karmaşıklıklarını basitleştiren akıcı bir yapı sunar. Sunucumuz yalnızca bir depolama aracı değildir; veri alımı ve hazırlığı da dahil olmak üzere çıkarımla ilgili etkinlikleri gerçekleştirecek donanıma sahiptir.

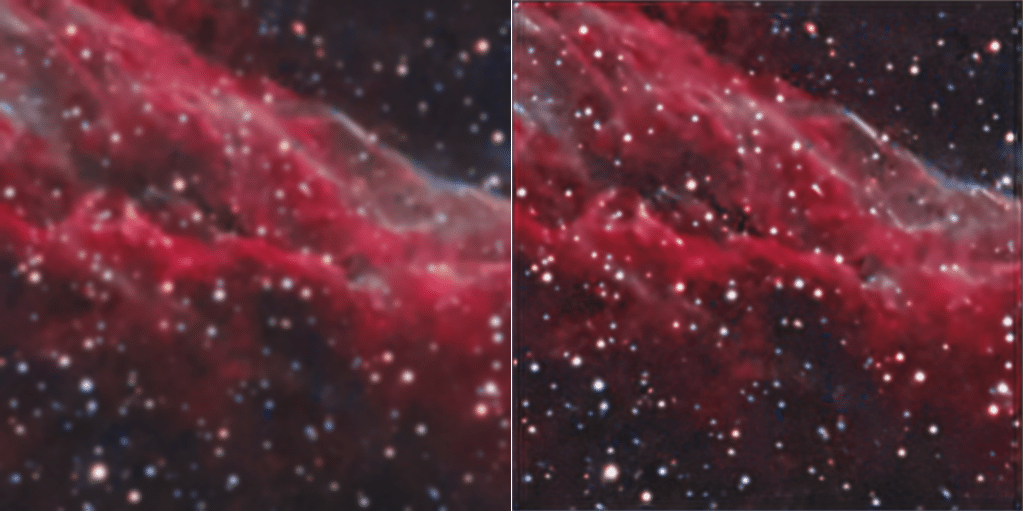

Daha büyük veri kümeleri üzerindeki çıkarımı test etmek için yaklaşık 1 Mb ile 20 Mb arasında değişen bir dizi astrofotografi görüntüsü seçtik ve bunlara karşı üzerinde çalıştığımız yeni bir CNN’yi çalıştırdık. Senaryomuzda model GPU’ya yüklenir ve ardından sinir ağı üzerinden işlenmek üzere bir görüntü veya görüntü dizisi yüklenir.

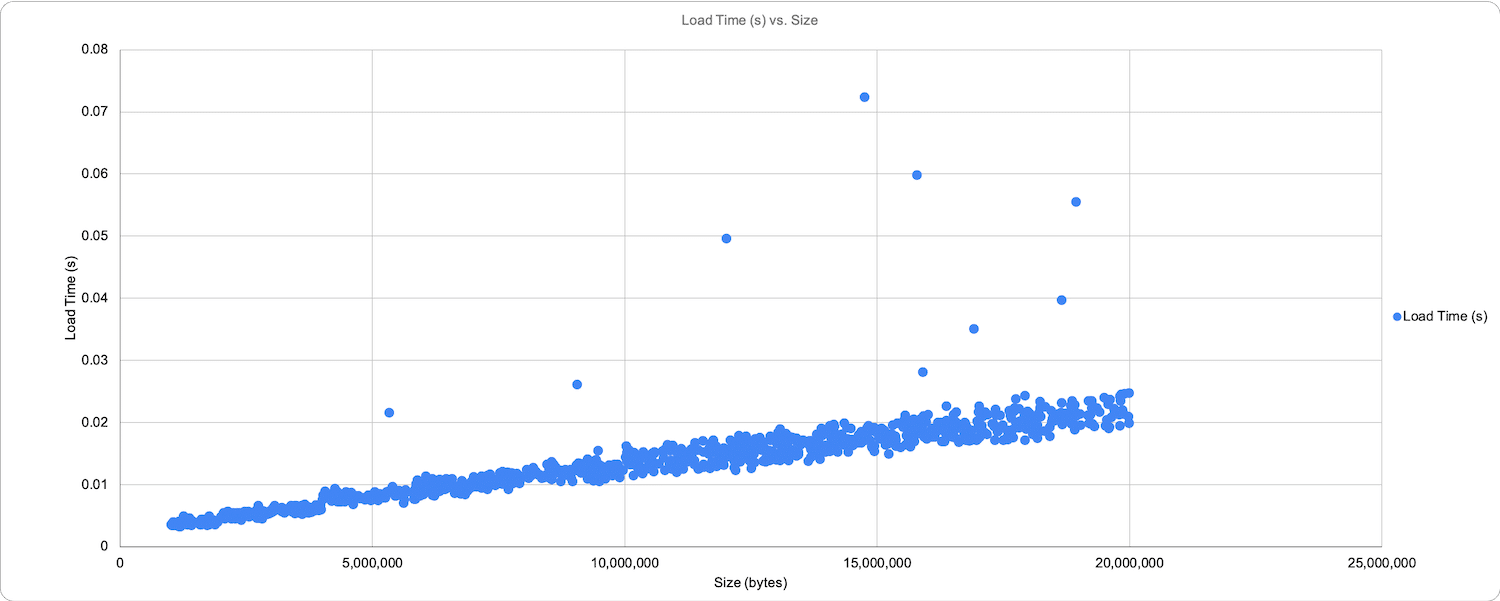

Bu, standart bir kameradan bilgisayarla görme nesnesi sınıflandırması gibi bir şeyde karşılaşacağınızdan daha geniş bir depolama alanı profilidir. Yine de platformun performansının esnekliğini ve tutarlılığını gösterdi. Yüklenme sırasına göre değil (birkaç aykırı değer dışında) boyuta göre sıralanan aşağıdaki grafikte, okuma süresi ve geri yazma süreleri uygun şekilde ölçeklendirilmiştir.

Bu grafiğin, sürücülerin ve sunucunun doğrusal performansını göstermek için en küçükten en büyüğe doğru sıralandığını unutmamak önemlidir. Gerçek çalışma ve veri seti rastgele seçilmişti, dolayısıyla 1 Mb’lik bir dosya okunup yazılabilirdi ve hemen ardından 20 Mb’lık bir dosya gelebilirdi. Gerçek işlemenin türü belirli bir sıraya göre değildi. Okuma süreleri 10 ms ile 25 ms arasında değişiyordu ve aykırı değerler 70 ms+ aralığına ulaşıyordu.

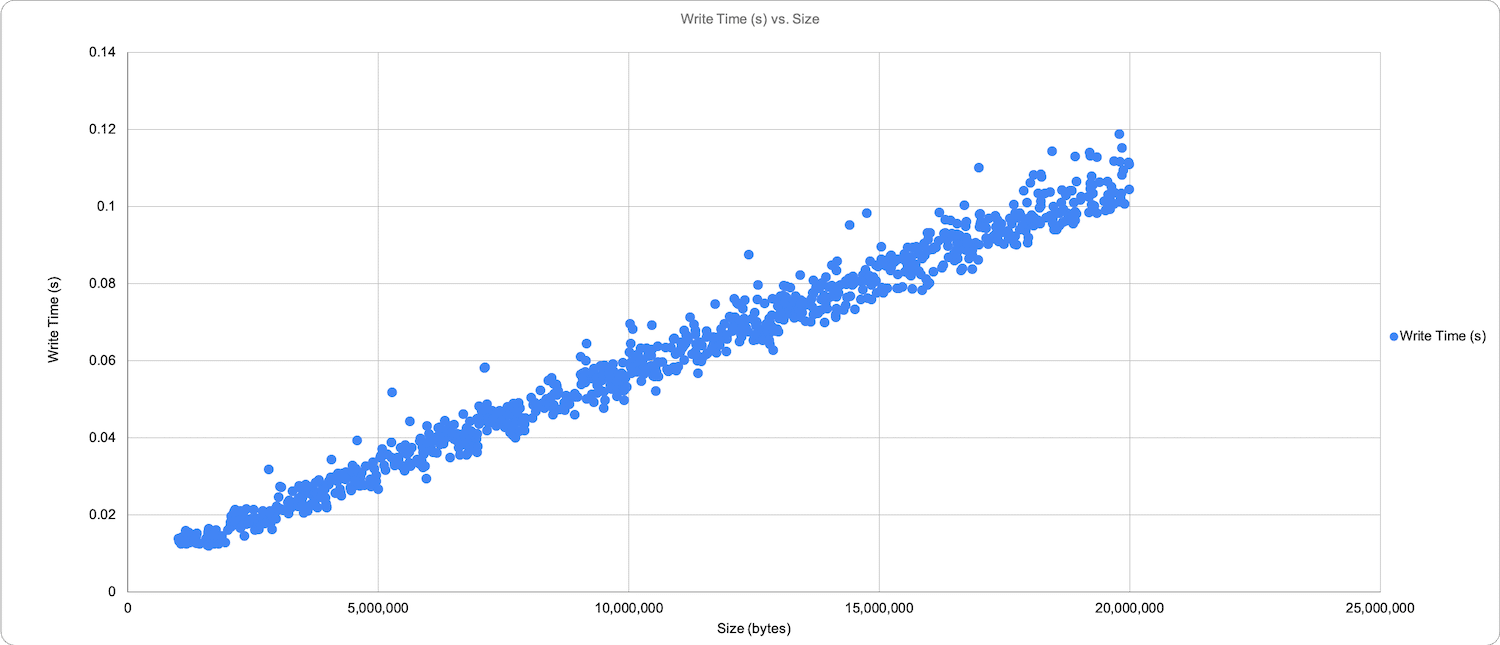

Aşağıdaki grafik, daha az sapma ile benzer şekilde doğrusal bir ilerlemenin yazılmasını göstermektedir ve aynı dosyaların 12 ms ile 118 ms arasında değişen yazma işlemlerini göstermektedir.

KIOXIA E1.S SSD’ler Hatırlanması gereken bir diğer önemli bilgi de, bu grafiğin, aynı veri kümesine yönelik bir çıkarımı aynı anda çalıştıran üç GPU iş istasyonundaki izlemenin bir toplamı olduğudur. KIOXIA sürücüleri, modelin kullandığı serileştirilmiş işleme hariç, 1000 görüntüden oluşan rastgele bir veri kümesine karşı çıkarım yapan etkileyici 10,5 GB’lık üç GPU iş istasyonuna hizmet verebildi ve geri yazabildi. Tek bir görüntünün okunması ve geri yazılması tüm süreç yalnızca 59,62 saniye veya 59 ms sürdü.

KIOXIA E1.S SSD’ler Hatırlanması gereken bir diğer önemli bilgi de, bu grafiğin, aynı veri kümesine yönelik bir çıkarımı aynı anda çalıştıran üç GPU iş istasyonundaki izlemenin bir toplamı olduğudur. KIOXIA sürücüleri, modelin kullandığı serileştirilmiş işleme hariç, 1000 görüntüden oluşan rastgele bir veri kümesine karşı çıkarım yapan etkileyici 10,5 GB’lık üç GPU iş istasyonuna hizmet verebildi ve geri yazabildi. Tek bir görüntünün okunması ve geri yazılması tüm süreç yalnızca 59,62 saniye veya 59 ms sürdü.

Bu tasarım birden fazla iş istasyonuna veya GPU sunucusuna ölçeklenebildiğinden, çeşitli seçenekler hızı ve gecikmeyi artırabilir. NVIDIA’nın GPUDirect Depolamasının RDMA (Uzaktan Doğrudan Bellek Erişimi) protokolüyle birlikte uygulanması, yüksek yoğunluklu paylaşılan depolamadan doğrudan GPU belleğine kesintisiz veri aktarımını kolaylaştıracaktır. Bu yaklaşım, CPU ve sistem belleği darboğazlarını etkili bir şekilde atlayacaktır. Yapılar ve NVIDIA ağ donanımı üzerinden NVMe’den yararlanılarak, büyük veri hacimleri GPU belleğine neredeyse gerçek zamanlı olarak önceden yüklenebilir. Bu, büyük veri kümeleri ve hesaplama talepleri göz önüne alındığında, LLM’lerle uğraşırken özellikle faydalı olacaktır. Böyle bir yetenek, verileri önbelleğe alma ihtiyacını ortadan kaldırabilir ve birden fazla iş istasyonunun aynı anda paylaşılan depolama havuzundaki verileri okumasına ve almasına olanak tanıyabilir.

Son düşünceler

KIOXIA E1.S SSD’ler Daha büyük modellerin G/Ç darboğazının ele alınması, özellikle geniş veri kümeleriyle uğraşırken makine öğreniminin devam eden gelişimi açısından çok önemlidir. Merkezi, yüksek hızlı ağ paylaşımı, geleneksel yerel depolamaya göre üç kat avantaj sunar.

- İlk olarak, büyük veri kümelerini eğitim için bireysel iş istasyonlarına taşıma ihtiyacını ortadan kaldırarak operasyonları kolaylaştırır. Bu, özellikle derin öğrenme modellerini içeren makine öğrenimi projelerini sekteye uğratabilecek G/Ç darboğazlarıyla doğrudan mücadele eder.

- İkincisi, merkezi bir yaklaşımı tercih ederek, iş istasyonunun değerli PCIe hatlarını aşırı ve hatta ulaşılamaz miktarlarda yerel depolamayla bunaltmaktan kaçınırsınız. Yüksek hızlı bağlantı sayesinde bu, daha fazla GPU’nun verileri paralel olarak daha verimli bir şekilde işlemesini sağlayarak makine öğrenimi işlemlerini daha yalın ve daha çevik hale getirebilir.

- Üçüncüsü, merkezi depolama doğası gereği daha iyi güvenlik önlemleri sağlar. Veriler güvenli, tek bir konumda depolandığında erişim kontrollerini yönetmek ve güvenlik protokollerini uygulamak daha kolay hale gelir; böylece veri ihlali, fiziksel tehdit veya yetkisiz erişim riski azalır.

KIOXIA E1.S SSD’ler Ek olarak, verilerin merkezileştirilmesi, gelişmiş veri tutarlılığı ve ek bir veri yedekliliği katmanı sağlar. İş istasyonları, en güncel verilere tek bir kaynaktan erişerek, eski veya tutarsız eğitim veya verilere veya model kontrol noktalarına ince ayar yapılması nedeniyle sonuçlardaki tutarsızlıkları en aza indirir. Bu aynı zamanda veri yönetimini basitleştirir ve depolama alanından tasarruf sağlar.

Hipersonik olarak gelişen yapay zeka ve makine öğrenimi ortamında ölçeklenebilirlik, verimlilik ve güvenlik giderek daha önemli hale geldikçe, KIOXIA E1.S platformu gibi teknolojilerin sağladığı merkezi, yoğun, yüksek hızlı depolamaya geçiş zorlayıcı bir durum sunuyor. Bu, yalnızca gelişmiş performans açısından değil, aynı zamanda veri yönetimi ve model eğitimine yaklaşımımızdaki temel dönüşüm açısından da kritik öneme sahiptir.