NVIDIA L40S NVIDIA H100 Yapay Zeka Alternatifidir

NVIDIA L40S NVIDIA H100 Yapay Zeka Alternatifidir

NVIDIA L40S NVIDIA H100 Yapay Zeka Alternatifidir. Biz bu makaleyi yazarken, NVIDIA H100 80GB PCIe, CDW gibi çevrimiçi perakendecilerde 32 bin dolardır ve yaklaşık altı ay boyunca ön siparişe açılmıştır. Anlaşılır bir şekilde, NVIDIA’nın üst düzey GPU’sunun fiyatı (neredeyse) her şeyi yapıyor ve talep de son derece yüksek. NVIDIA, birçok yapay zeka kullanıcısı ve kurumda gözden kaçan karma iş yükleri çalıştıranlar için bir alternatif ortaya çıkardı, ancak bu çok iyi. NVIDIA L40S, hızla yapay zeka alanında en iyi saklanan sır haline gelen grafik odaklı L40’ın bir çeşididir. Şimdi derinlemesine inceleyelim ve nedenini anlayalım.

Bize donanım sağlayarak bu parçayı desteklediği için Supermicro’ya teşekkür etmek istedik. Elde edilmesi zor birçok NVIDIA parçasına erişmemizi sağladıklarından, bu parçaya sponsor olduklarını söyleyeceğiz.

NVIDIA A100, NVIDIA L40S ve NVIDIA H100

Öncelikle, bugün ChatGPT gibi temel modelleri eğitmek istiyorsanız NVIDIA H100 80GB SXM5’in hala tercih edilen GPU olduğunu söyleyerek başlayalım. Temel model eğitildikten sonra, alana özgü verilere veya çıkarımlara dayalı bir modelin özelleştirilmesi genellikle önemli ölçüde daha düşük maliyetli ve daha düşük güçlü parçalar üzerinde yapılabilir.

Günümüzde üst düzey çıkarım için üç ana GPU kullanılıyor: NVIDIA A100, NVIDIA H100 ve yeni NVIDIA L40S. Daha düşük seviye bir çıkarım kartı olduğu için NVIDIA L4 24GB’yi atlayacağız .

NVIDIA L40S NVIDIA H100 Yapay Zeka Alternatifidir. NVIDIA A100 ve H100 modelleri, şirketin kendi nesillerindeki amiral gemisi GPU’larını temel alıyor. SXM modülleri yerine PCIe’yi tartıştığımız için form faktörleri arasındaki en önemli iki fark NVLink ve güç tüketimidir. SXM modülleri, daha yüksek güç tüketimi (PCIe versiyonlarının yaklaşık iki katı) ve çoklu GPU düzeneklerinde NVLink ve genellikle NVSwitch topolojileri aracılığıyla birbirine bağlanacak şekilde tasarlanmıştır. En yeni Supermicro SYS-821GE-TNHR 8x NVIDIA H100 AI sunucu parçamızda mevcut olan en üst düzey sistemlerden birinin bir örneğini görebilirsiniz .

NVIDIA A100 PCIe, 2020’de 40 GB model olarak piyasaya sürüldü ve ardından 2021’in ortalarında şirket, teklifi A100 80 GB PCIe eklenti kartına güncelledi . Yıllar sonra bu kartlar hala popülerdir.

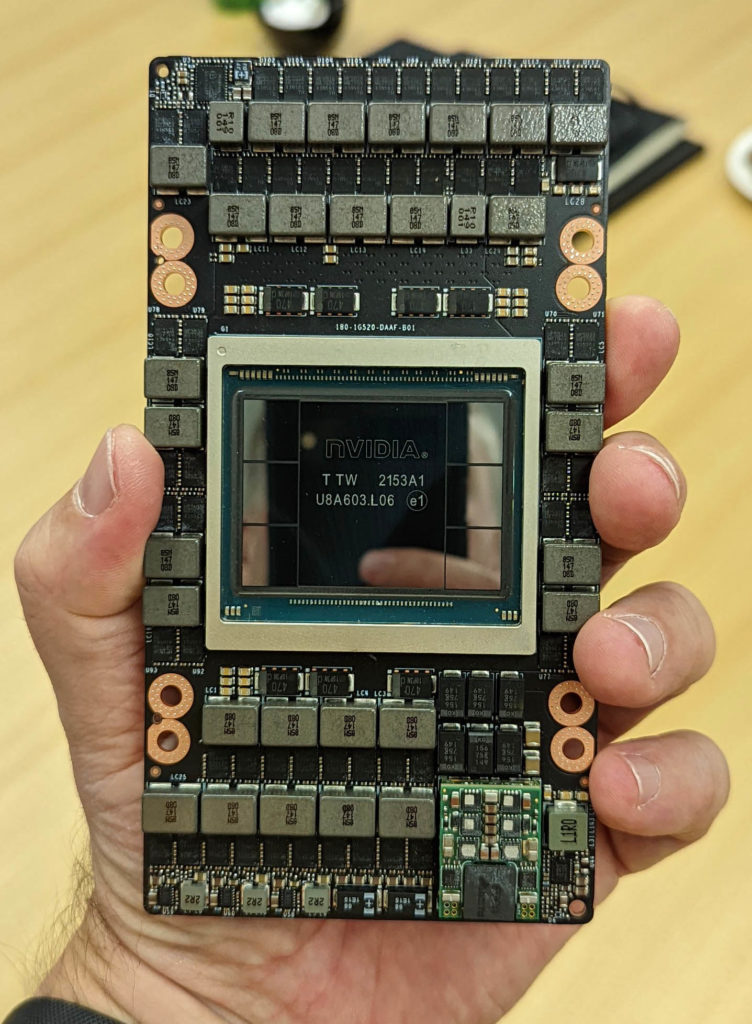

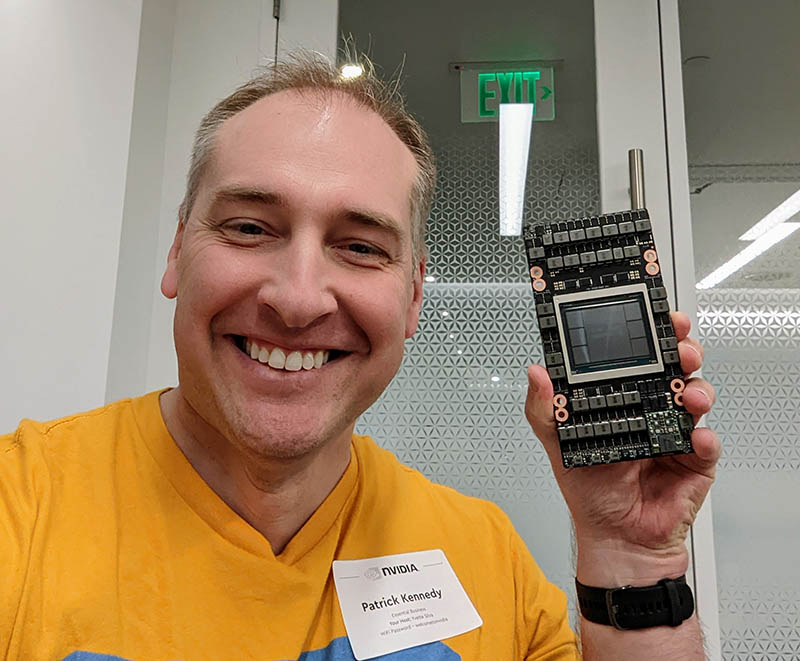

NVIDIA H100 SXM5 modülünü ilk kez 2022’nin başlarında uygulamaya başladık , ancak PCIe Gen5 CPU’ların kullanıma sunulmasıyla sistemler 2022’nin sonlarında ve 2023’ün başlarında ortaya çıkmaya başladı.

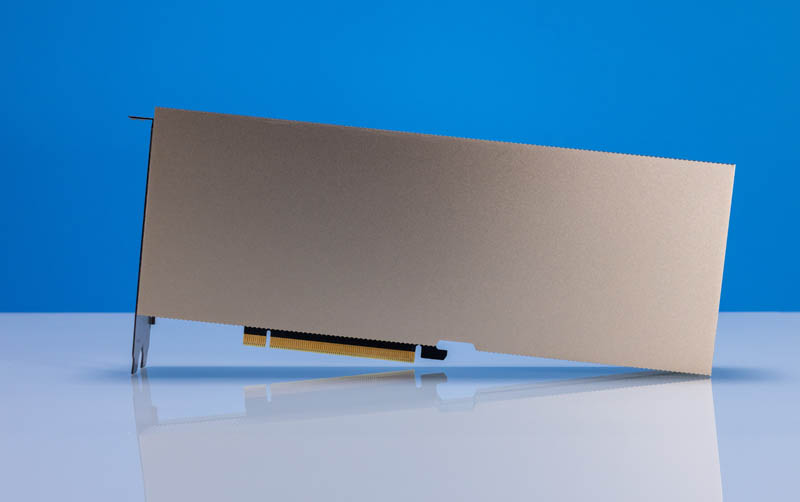

NVIDIA H100 PCIe, ana akım sunucular için tasarlanmış düşük güçlü H100’dür. PCIe kartını düşünmenin bir yolu, daha düşük performans ama aynı zamanda çok daha düşük güç tüketimi için tasarlanmış voltaj/frekans eğrisinin farklı bir kısmında çalışan benzer miktarda silikondur.

H100 hattında bile bazı farklılıklar var. NVIDIA H100 PCIe hala bir H100’dür, ancak PCIe form faktöründe performansı, güç tüketimini ve bazı ara bağlantıları (örneğin, NVLink hızları) azaltmıştır.

L40S oldukça farklı bir şey. NVIDIA, NVIDIA’nın en yeni Ada Lovelace mimarisini kullanan bir veri merkezi görselleştirme GPU’su olan temel L40’ı aldı ve görselleştirmeden çok yapay zekaya göre ayarlanması için ayarları değiştirdi.

NVIDIA L40S, Işın İzleme çekirdekleri ve DisplayPort çıkışları ile L40’ın AV1 desteğine sahip NVENC / NVDEC gibi özelliklerini koruduğu için büyüleyici bir GPU’dur. Aynı zamanda NVIDIA, GPU’nun AI kısımlarındaki saatleri yönlendirmek için daha fazla güç aktarıyor.

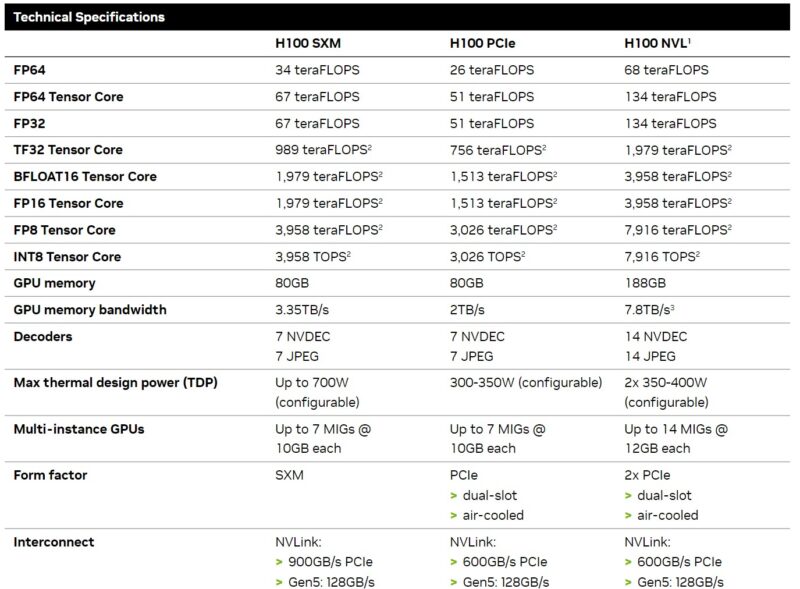

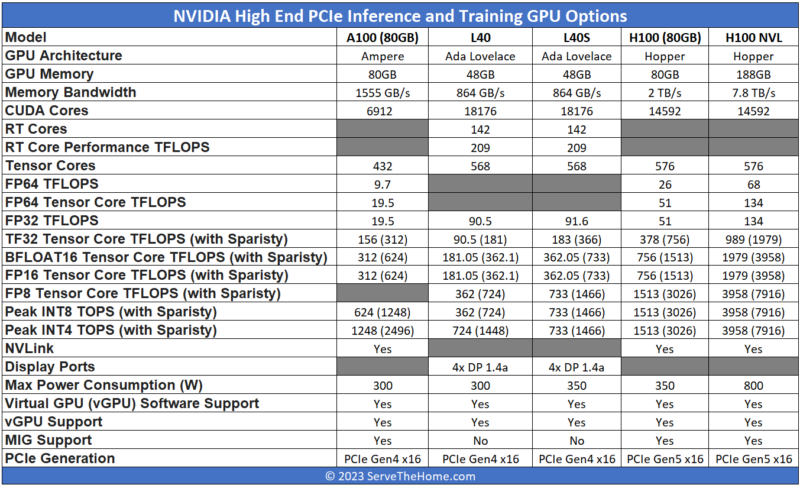

Görselleştirmeyi kolaylaştırmak için bunu bir grafiğe koyduk. NVIDIA’nın teknik özellikleri bazen NVIDIA kaynağının bir görünümüne göre bile farklılık gösterir, dolayısıyla bulabildiğimiz en iyi şey bu ve teknik özelliklerle ilgili bir güncelleme alırsak onu da güncelleyeceğiz. Ayrıca , aralarında bir NVLink köprüsü bulunan iki gelişmiş H100’ün bulunduğu çift kartlı H100 NVL’yi de dahil ettik; geri kalanlar tek kartken bunu çift kartlı bir çözüm olarak değerlendirin.

Burada incelemeye değer birkaç nokta var:

- L40S, L40’a kıyasla yapay zeka eğitimi ve çıkarımı için büyük ölçüde geliştirilmiş bir karttır, ancak ortak miras kolayca görülebilir.

- Mutlak bellek kapasitesine, bant genişliğine veya FP64 performansına ihtiyacınız varsa L40 ve L40S uygun kartlar değildir. Bugünlerde yapay zeka iş yüklerinin geleneksel FP64 hesaplamasını devraldığı göreceli pay göz önüne alındığında, çoğu kişi bu ödünleşimi fazlasıyla kabul edecektir.

- L40S, NVIDIA A100’den önemli ölçüde daha az belleğe sahip gibi görünebilir ve fiziksel olarak öyledir, ancak hikayenin tamamı bu değil. NVIDIA L40S, NVIDIA Transformer Engine ve FP8’i destekler. FP8’in kullanılması, veri boyutunu büyük ölçüde azaltır ve bu nedenle, bir FP8 değeri, FP16 değerine göre daha az bellek kullanabilir ve taşımak için daha az bellek bant genişliği gerektirir. NVIDIA, Transformer Engine’i zorluyor çünkü H100 de onu destekliyor ve AI parçalarının maliyetini düşürmeye veya performansını artırmaya yardımcı oluyor.

- L40S’de görselleştirme ağırlıklı bir video kodlama/kod çözme seti bulunurken, H100 kod çözme tarafına odaklanır.

- NVIDIA H100 daha hızlıdır. Aynı zamanda çok daha pahalıya mal oluyor. Bir anlamda, halka açık fiyatları listeleyen CDW’de H100, bunu yazdığımız sırada L40S’nin fiyatının yaklaşık 2,6 katı civarında.

- Bir diğer büyük sorun ise kullanılabilirliktir. Bugünlerde NVIDIA L40S almak, NVIDIA H100 için sırada beklemekten çok daha hızlı.

İşin sırrı, AI donanım tarafında ilerlemenin yeni ve yaygın bir yolunun, model özelleştirme ve çıkarım için H100’ü kullanmamak olmasıdır. Bunun yerine, yıllar önce ele aldığımız tanıdık bir mimariye, yoğun PCIe sunucusuna geri dönüş var. 2017’de DeepLearning11 yaptığımızda, NVIDIA GeForce GTX 1080 Ti’leri bir sunucuya sıkıştıran 10x NVIDIA GTX 1080 Ti Tek Köklü Derin Öğrenme Sunucusu, dünyanın belirli yerlerinde arama/web hiper ölçekleyicileri gibi büyük şirketler için bile tercih edilen mimariydi ve otonom sürüş şirketleri.

NVIDIA, EULA’sını bu tür bir yapılandırmayı yasaklayacak şekilde değiştirdi ve yazılımının yapay zeka çıkarımı ve eğitimi için veri merkezi parçalarına daha fazla odaklanmasını sağlıyor; dolayısıyla artık işler farklı.

2023’te aynı konsepti, NVIDIA L40S versiyonuyla (ve sunucu “çarpınması” olmadan ) düşünün.

L40S sunucuları satın alarak ve H100’e kıyasla daha düşük maliyetli GPU’lar alarak benzer performansı muhtemelen daha düşük bir fiyata elde edebilirsiniz.

Supermicro SYS-521GE-TNRT Sunucularında NVIDIA H100 veya L40S

Günümüz sistemlerinde çok farklı olan şey, onların artık tam 5U olmasıdır. Bunun nedeni genellikle her GPU, H100 veya L40S’nin TDP’sinin 350W olmasıdır. Genellikle bu sistemlerde GPU’larda yaklaşık 2,8kW için sekiz GPU bulunur. Diğer sebep ise iki seçenek arasında bu sistemlerin genellikle 4,3-5kW aralığında güç kullanmasıdır. Bu da onları 208V 30A raf başına tek bir sunucu veya daha yüksek güçlü bir rafta birden fazla sunucu için yeterli kılar. Raflardaki güç ve soğutma çoğu zaman daha büyük sınırlayıcı olduğundan, modern yapay zeka sunucularında yoğunluk daha az zorlayıcıdır.

Bu ekstra 1U alan, GPU’ların daha fazla soğutulmasına olanak tanır. NVIDIA GPU’lar ve H100 ile L40S de bu yolu izler ve genellikle maksimum nominal güçlerini kullanabilirler, ancak genellikle ortalama olarak nominal güçlerinden daha azını kullanırlar.

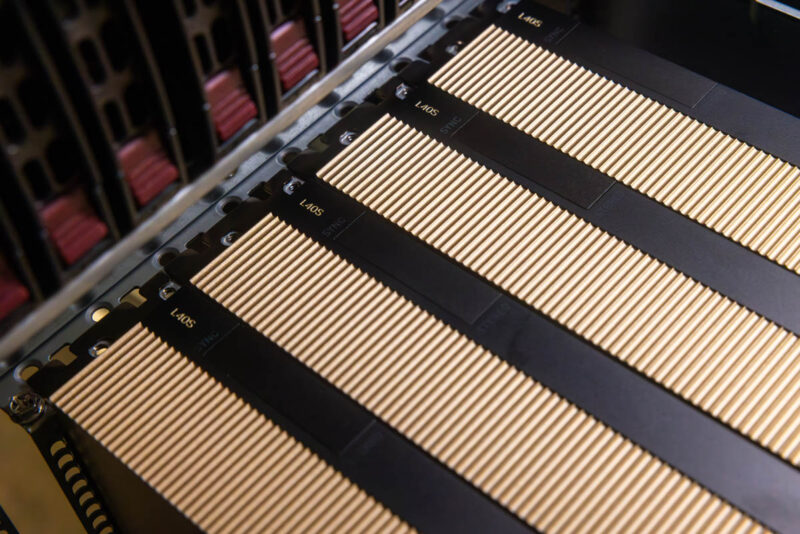

Supermicro, kasanın hem Intel Xeon hem de AMD EPYC versiyonlarına sahiptir. Biri 8x NVIDIA H100 GPU’lu olmak üzere iki Intel Xeon sürümü kurduk.

Ve diğeri NVIDIA L40S kartlarıyla.

Bunların sadece sekiz kartla kurulduğunu görüyorsunuz, ancak bu sistemler bir zamanlar DeepLearning11’de kullandığımız gibi 10’a kadar ölçeklenebilir.

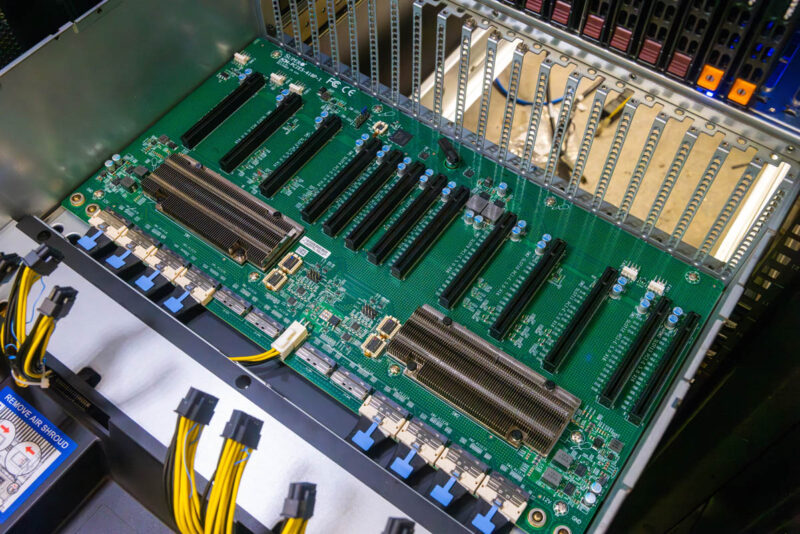

PCIe GPU sunucularında, GPU’ların nasıl bağlandığı, NVLink olmadan PCIe anahtarı üzerinden P2P gibi şeyler ve NVIDIA NCCL’nin iş yükünde ne kadar iyi çalıştığı açısından önemlidir. NCCL, işleri birden fazla GPU’ya ölçeklendirmek için önemlidir. Supermicro SYS-521GE-TNRT, çift kök yapılandırmasında PCIe Gen5 anahtarlarını kullanır. GPU kartındaki soğutucuların altında iki PCIe anahtarı görülebilir ve bu kart, sistemlerdeki anahtarlar ve CPU’lar arasında kablolanmıştır.

NVIDIA H100’ler, çiftler halinde NVLink köprü bağlantı kartları kullanılarak bu sunucuya kurulabilir. L40S’e baktığımızda her şey PCIe’dir.

Performans Özeti

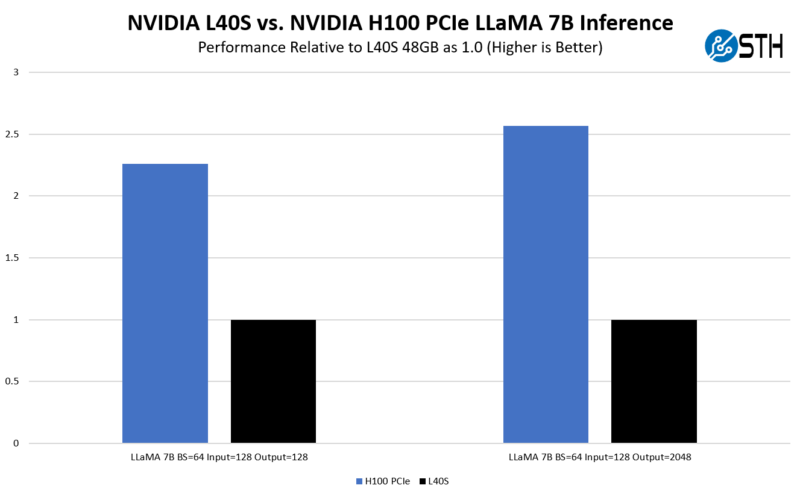

Bu GPU’larda LLaMA 7B çıkarımını çalıştırdık. Onlara erişebildiğimiz çok kısa bir zamanımız vardı, bu da koştuğumuz şeyi sınırladı. NVIDIA yapay zeka için çok sayıda sayı yayınlıyor; bu nedenle bunlara göz atmaktan çekinmeyin. Bu parçayı zamanla birkaç tane daha güncelleyeceğimizi umuyoruz.

Sonuçlarımızı NVIDIA’nın resmi rakamlarıyla karşılaştırdık . Resmi sonuçlara göre NVIDIA, PCIe sürümünü değil H100 SXM5’i kullanıyor, ancak SXM5 sürümünün PCIe sürümünden yaklaşık %25 daha hızlı olduğu (ancak iş yüküne göre değişir) şeklinde bir genel kural kullanıyoruz ve sanki biz Basketbol sahasındayız.

Bu bizi şu açık noktaya getiriyor: H100 daha hızlıysa neden L40S? İnsanların bunları dağıtmasının nedeni, özellikle FP8 kullanıldığında, A100 ile, hatta FP16 kullanan SXM sürümüyle bile rekabet edebilmek için 48 GB’ın yeterli bellek olması. Öte yandan, genel olarak H100 PCIe’nin L40S’den 2,0-2,7 kat daha hızlı olduğunu görüyoruz, ancak fiyatı da 2,6 kat daha yüksek. L40S, H100’den çok daha erken bir zamanda satışa sunulacak ve bazı anlaşma fiyatları, L40S’yi H100 ile daha da rekabetçi bir seviyeye getirerek teraziyi L40S lehine daha da değiştiriyor.

Birkaç uyarı var. 10.000’den fazla GPU dağıtıyorsanız NVIDIA, NVSwitch ve diğer teknolojilerle Delta Next platformlarında yalnızca H100’e değil aynı zamanda H100 SXM5’e de odaklanıyor. Bunu NVIDIA’ya sorduk ve örneğin “yalnızca” 4000 GPU (muhtemelen ~50 milyon ABD Doları + donanım) dağıtıyorsanız, L40S tercih edilecek çözümdür.

NVIDIA L40S ve H100 ile İlgili Diğer Hususlar

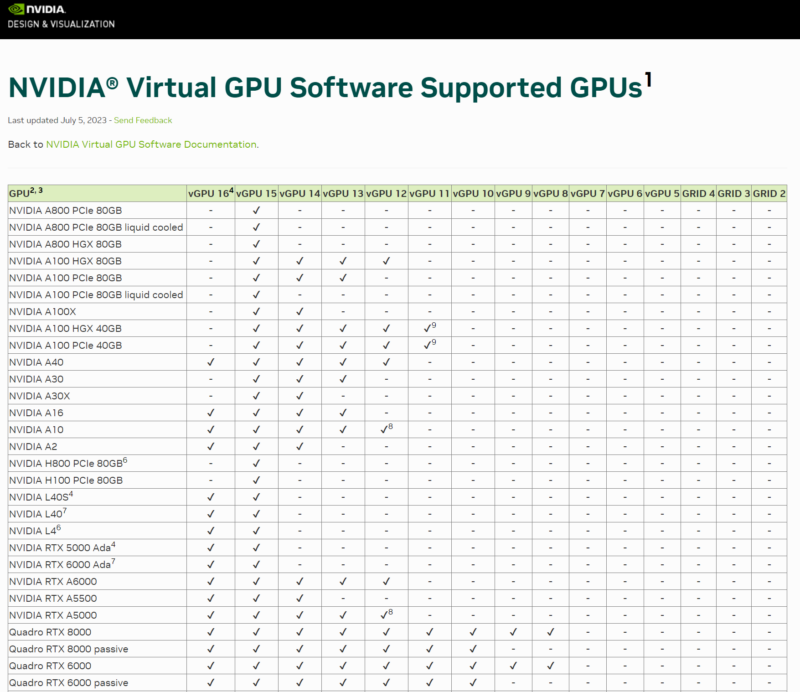

L40S’de dikkate alınması gereken başka hususlar da vardır. Birincisi, NVIDIA Virtual GPU vGPU 16.1’i desteklemesi , oysa H100 hala yalnızca vGPU 15 ile destekleniyor. NVIDIA, AI yongalarını vGPU desteği tarafından biraz ayırıyor.

Bir tür GPU makinesini dağıtmak ve ardından farklı türdeki iş yüklerini çalıştırabilmek isteyenler için L40S gibi bir şey mantıklı olacaktır. Ayrıca görselleştirme kökleri göz önüne alındığında, AV1 desteğine ve RT çekirdeklerine sahip NVIDIA video kodlama motorlarına da sahiptir.

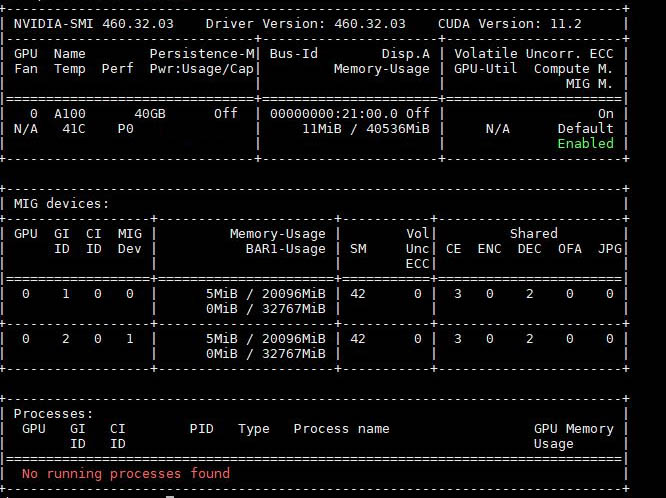

L40S’in desteklemediği bir özellik var, o da MIG. MIG’e daha önce bakmıştık ancak bu, H100’ün farklı boyutlarda 7 bölüme kadar bölünmesine olanak tanıyor. Bu çoğunlukla H100 GPU’yu genel bulutlara bölmek ve böylece GPU kaynaklarının müşteriler arasında paylaşılabilmesi için kullanışlıdır. Bir kuruluş için bu genellikle daha düşük heyecan verici bir özelliktir.

Ayrıca, L40S’nin konuşlandırılması, SXM5 sistemlerinin gücünün yarısı kadar olan daha düşük bir güç meselesidir. Bu, ölçeğini genişletmek isteyen ancak her raf için büyük güç bütçeleri olmayanlar için onu çok çekici kılıyor.

Sonuç olarak L40S, H100 kadar hızlı değildir, ancak NVIDIA’nın FP8 ve Transformer Engine desteğiyle, birçok kişi için H100’den daha kullanılabilir ve dağıtımı daha kolay olan ve genellikle daha düşük maliyetli bir seçenektir. maliyet.

Son sözler

NVIDIA H100 PCIe ve L40S karşılaştırması ve neden her iki sürümün de kullanılması gerektiği konusunda pek çok zayıf bilgi var. Umarım bu, bunu daha büyük ölçüde açıklığa kavuşturmaya yardımcı olur. Bizim için L40S ucuz gelmiyor ama bize yapay zekada yapılacak şeyin sunucularda daha düşük maliyetli NVIDIA GPU’lar kullanıp daha sonra daha fazlasını kullanmak olduğu 6+ yıl öncesini hatırlatıyor. NVIDIA, L40S’yi ve birkaç bine kadar GPU’yu destekleyen resmi olarak onaylanmış bir mimariyi kullanan bu modele yeniden sahip.

Bunu destekledikleri için Supermicro ve NVIDIA’ya kısa bir teşekkür ederiz. Bu, hala NVIDIA olan iyi bir H100 alternatif mimarisinin ne olduğuyla birlikte karşılaştığımız bir soru gibi görünüyor. L40S gerçekten birçok müşterinin yanıtıdır.